AI Master Degree

Analysis of Variance

ANOVA = Analysis of Variance 분산분석 분산분석은 독립변수가 하나이고 측정 집단이 3개 이상일때, 그 결과를 검증할때 사용한다. 예외로 T-test와 Paired T-test는 독립변수가 하나이고 집단이 2개일 때만 사용할 수 있다. Treatment : Cyl 실린더, Multiple Observations y-bar : Global Average , 각각 실린더에 따른 평균을 구한다. SS = Sum of Squares 제곱합 각각의 평균에서 전체 평균(각 평균들의 평균)을 뺀 값을 제곱하여 총 개수 n을 곱한다.

Chap. Bayesian Classifiers

머신러닝 알고리즘 중에서 가장 단순, 적은 연산으로 훌륭한 성능을 보여주는 분류기 Classifier 이다. Posterior = Likelihood x Prior / Model Evidence 사후 확률 가능도 사전확률 모델에 대한 증거 H : 가설, E : 증거 베이지안 이론 예제 환자가 Stiff neck 을 가졌다면, meningitis 일 확률은 얼마일까? meningitis 가 stiff neck 을 발병할 확률은 50%, meningitis 사전 확률은 1 / 50,000, stiff neck 은 1/ 20 이다. 베이지안 이론에 따른 P(M|S) 는 0.5 x 1/50000 / ( 1 / 20 ) = 0.0002 이다. M : Meningitis = Hypothesis 가설, S : Sti..

Chap 9. Statistics Part 2

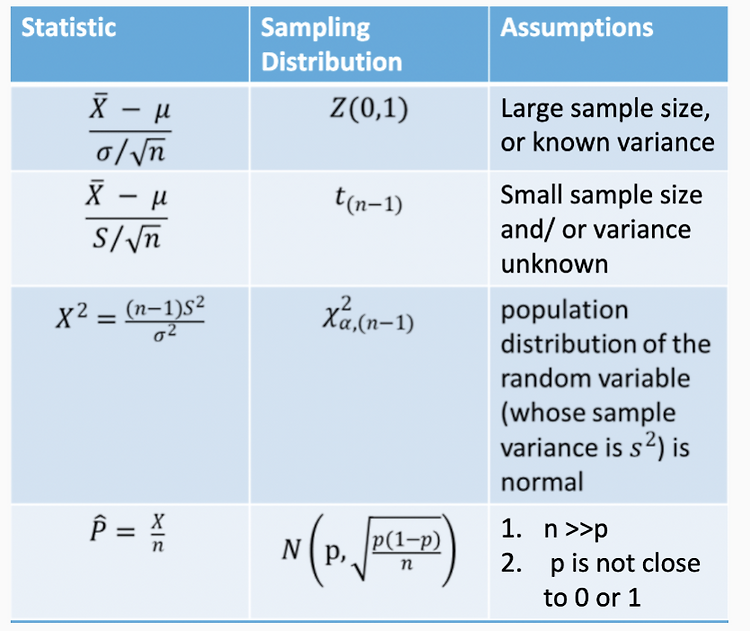

Confidence Intervals란? Confidence Intervals 신뢰구간은 모수가 실제로 포함되는 것으로 예측되는 범위이다. 전체를 연구하는 것은 어렵기 때문에 샘플링하여 모수 범위를 추정할때 신뢰구간을 사용한다. Standard Deviation : 20mm Mean : 175mm 10 bottles of the new Shampoo 파란 부분 : Critical Region Acceptable Region : Critical Region을 제외한 부분 162.6 175, Mu 187.4, mu = 175) = 0.025 + 0.025 = 0.05% 5%의 임의 샘플들은 ..

Chap 7. Decision Tree 결정 트리

Decision Tree 란? 일련의 분류 규칙을 통해 데이터를 분류하고 회귀하는 지도 학습(Supervised Learning) 모델이다. 데이터의 모양은 Tree Structure로 나타내기 때문에 Decision Tree라고 부른다. Decision Tree Induction Algorithm Hunt's Algorithm CART ID3, C4.5, C5.0 SLIQ and SPRINT Decision Tree는 Attribute 속성과 어떻게 의사결정을 몇개로 나눌 것인지에 따라 다르게 형성할 수 있다. Attribute types : Binary, Nominal, Ordinal, Continuous Split way : 2-way split, Multi-way split Nominal Attr..

Midterm Preparation : Data Mining

목차 WSS, BSS Minkowski Jaccard coefficient Bisecting K means DBSCAN BSS, WSS, SSE란? SSE : WSS WSS : Within sum of squares 군집 내에서의 응집력(Cohesion)을 의미한다. BSS : Between-group sum of squares 군집이 다른 군집과 얼마나 다른지, 잘 분리되어 있는지를 의미한다. SSE : Total sum of squared Errors K 는 cluester들의 수를 의미한다. WSS와 BSS를 합하면 클러스터 수와 상관없이 일정하다. Minkowski Distance란? 유클리드 거리와 맨해튼 거리를 일반화 한것이다. p = 1 : 맨허튼 거리와 동일, L1 Norm p = 2 : ..

Chapter 3. Data preprocessing이란?

Aggregation Sampling Dimensionality Reduction Feature Subset Selection Feature Creation Discretization and Binarization Attribute Transformation Aggreation이란? 두개 혹은 세개 이상의 Attribute, Object들을 결합하여 하나의 Attribute, Object를 만드는 것이다. 목적 Data reduction : Attributes, Objects의 수를 줄일 수 있다. Change of scale : 규모를 변경하는데, 도시들을 지역이나 나라로 혹은 일을 주, 월, 년으로 수정한다. More Stable data : 변동성이 적은 데이터로 만들 수 있다. Sampling이란..

Chapter 2. Data 타입이란? Missing value란? Outliers란? (Data Mining)

Data 란? 데이터 객체들과 그들의 Attributes-속성들의 수집 형태. Attribute 란? 한 객체의 속성이나 특성. 또한 Attribute 는 variable, field, characteristic, feature로도 알려져있다. 여러 개의 Attribute가 하나의 객체를 묘사, 설명한다. 즉 하나의 객체는 여러개의 Attribute로 구성되어 있다. Example : Eye color, Temperature Measurements 란? 규칙이나 함수로써 값들을 Attribute로 할당하는 방법이다. Mearsurement 자체가 각각 Attributes의 속성들을 모두 만족, 매칭시키지 않으며 각 상황, 조건 등에 의해 다양한 Measurement가 가능하다. Attribute의 형태?..

Chapter 1. Data mining이란?

Data Mining Tasks Descriptive methods : Find human-interpretable patterns that describe the data. Example : Clustering, Pattern Mining 설명 방식은 사람이 이해할 수 있는 패턴으로 데이터를 설명한다. 예를 들어 클러스터링, 패턴 마이닝 등이 있다. Predictive methods : Use some variables to predict unknown or future values of other variables Example : Recommender Systems, Time Series Analysis 몇몇 변수들을 사용하여 예측 방식은 알려지지않거나 미래의 값들 예측한다. 예를 들어, 추천시스템..